外国竞争对手的计算性能快了5倍。 Tsinghua团队提

作者:BET356官网在线登录日期:2025/05/31 浏览:

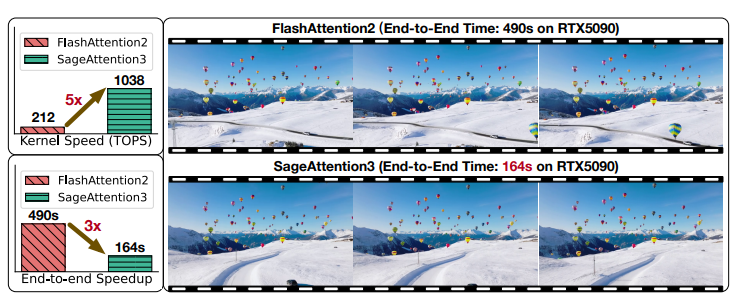

资料来源:DeepTech最近,Tsinghua大学团队创建了第一个小型FP4注意机制,用于加速理解-SageAttention3,该机制在NVIDIA RTX5090上实现了1038台计算性能。与FlashTtention3相比,NVIDIA RTX5090和Stanford University在美国建议的计算性能最快,在美国建议,SageAttention 3的计算性能更快了5倍。实验表明,SageAttention3可以加速不同的模型,而不会导致端到端质量指标的下降。同时,研究团队还创建了第一个训练有素的8位关注机制来加速培训-SageBWD,并探索了其在培训活动中的可行性。发现8位注意机制无法对gawaing微调实现绩效损失,但是在当前阶段仍有特定的训练活动限制。 。为此,他们提高了效率两个主要贡献的关注:首先,研究小组在NVIDIA的Blackwell GPU中使用了新的FP4张量核心来加速注意力计算。实验表明,sageattention3可以在插件方法中加速不同模型的推理。其次,研究小组首先采用了低位的注意机制进行培训活动,而现有的低位注意机制(包括Flashttention 3和Sageattention)仅着重于推理。就研究团队的实现而言,这项研究实现了FP4机制的首次预防措施加速设计,并赦免了低型物体对大型训练的可行性。当前,相关代码是开放资源:https://github.com/thu-ml/sageattention。解决研究团队的两个主要障碍和一个困难在本文中指出,FP4的注意机制面临两个主要障碍,而8位注意机制面临着主要的困难。 PartiCularly:第一个问题是FP4体积表示数是高度限制的(只有15个有利值),如果模型是每张量或每键的量方法,则无法有效地维持模型的准确性。第二个问题是:注意图P主要由范围内的少量组成[0,1]。 。但是,硬件要求必须通过fp8数据对数量因子进行分类,当缩放因子以FP8格式表示时,此限制会导致准确性显着。第三个问题是:在训练过程中使用8位注意机制时,研究小组发现注意力图的梯度特别容易出现体积误差,从而导致输入梯度误差的积累。为了解决第一个问题,研究团队提出了对注意机制的两倍矩阵繁殖,尤其是QK⊤和PV中使用的FP4显微镜方法的方法。通过将体积组大小限制为1X16(而不是基于男高音或通道),此过程可以有效防止异常值对每个块的影响,同时提高FP4体积的准确性。为了解决第二个问题,研究团队建议将两个级别的卷方法用于地图pa p,以便使用fp8缩放系数的完整范围,并改善了地图的注意力量。具体而言,该方法首先将[0,448×6]中每个令牌的数量归一化,然后使用token-by-by-by-token量使用FP4 microsmoss fictization for vantization f. ventization vantization vantization。为了解决第三个问题,研究团队确定了一个对返回批准的矩阵繁殖操作最敏感的问题,并在FP16水平上保持其准确性。 FP4注意超速,硬件实现和优化。在数据类型确定方面,FP4数据类型具有两个选项。第一个选项是NVFP4,其数据类型为E2M1,体积块的大小为1×16,aND扩展因子是E4M3数据类型。 AOF第二选项是MXFP4,它也是E2M1数据的类型,但是其体积块大小为1×32,扩展因子是E8M0数据类型。经过几次比较后,研究小组选择了NVFP4,因为NVFP4比MXFP4具有更高的注意力精度。下表显示了在AI Cogvideox视频生成的所有层中使用MXFP4和NVFP4的准确性。结果表明,NVFP4的精度比MXFP4更好。 。研究团队方法是通过允许瓷砖柱来调整累加器的布局。为了确保矩阵复制的准确性,研究团队可以相应地重新安排K列,可以与内核的体积一起处理。执行迷你缩放量化时,您需要找到每行连续16个元素的最大值。但是,这16个元素分布在4个线程中,这些线程需要最大值首先,线程,然后在线程之间传递休假。将E操作组合在一起,这大大减慢了内核实现的速度。研究团队将使用在线软智能中优化该方法的音量过程过程,而该融合也可以计算每行的最大值。 。通过安排乒乓球,消费者线束之间的阶段重叠。但是,在研究团队的FP4注意内核中,由于注册资源有限,无法实施此过程。因此,研究团队设计了一种新的解决方案,特别是在制造商线程捆绑包之间安排乒乓SA:当线程捆绑制造商存储输出商店时,将在全球内存中储存,而消费者螺纹捆绑包负责将矩阵重现从寄存器转移到共享内存中。通过采用这部小说的设计,他们将实现矩阵和G的重叠繁殖寄存器数量下的Lobal存储器存储操作,从而改善了吞吐量。 INT8注意用于训练,并进行相关的实验。据了解,与注意相关的注意相关的低位数量,例如Flashhattention3和Sageattention,仅适用于理解背景。如前所述,研究团队提出了INT8的训练注意机制 - SageBWD。该机制以INT8精度计算的七个矩阵繁殖中的六个计算,同时在调整调音中实现了零性能损失。在实验中,研究团队证实了SageAttention3和SageBWD的有效性,例如语言,图像和视频的各种代表性模型。具体来说,他们进行了实验:在文本到文本到文本测试实验中,使用了qwen2.5和llama3.2;在文本到视频测试实验中,使用了Cogvideox,Hunyuanvideo和Mochi。在文字中 - 使用了图像测试实验,通量和稳定的 - 扩散3.5。研究团队将此方法与FlashTtention 2,Xformers,Sageattention和Sageattention进行了比较。应该注意的是,FlashTtention3只能在NVIDIA HOPPER GPU上运行,因此FlashTtention 2是可以在NVIDIA RTX5090和NVIDIA RTX4090上运行的最快版本。下图显示了SageAttention3及其基线模型在RTX 5090主操作速度下。可以看出,与Flashhattention 2相比,SageAttention3的加速度已达到4至5倍,与Xformers相比,加速度的加速度为8至11倍。 。 。结果表明,SageAttention3在这些模型中几乎没有端到端质量损失。 (来源:ARXIV)为了评估SageBWD在培训活动中的有效性,研究小组进行了两个实验。首先,研究团队在GSM8K,DROP,MMLU和HELLASWAG数据集上精致的QWEN2.5(3B)和LLAMA3.2(1B)的主要模型精致。下图显示了LOS的结果调谐的s,表明SageBWD与BF16完全排列。 。 。下面的图显示了曲线的损失,表明即使SageBWD可以实现收敛的损失,但其收敛速度相对较慢。此限制阻止了其在训练前活动中的可用性。 。结果表明,SageAttention3保持了完整的质量一代。 。结果表明,与Hunyuan和Cogvideox相比,Sageattention 3在NVIDIA RTX5090中达到了大约3倍和2.4倍的端到端加速。此外,使用NVIDIA RTX4090中的8K/16K令牌Microbatch训练Llama(1B)时,SageBWD达到了约1.15倍的加速度。 (来源:ARXIV)尽管SageBWD的性能比FP16更快,但是研究团队已经观察到其当前速度和理论上限之间存在显着差距。该空间可能是由于缺乏Triton内核的实施而引起的,研究团队计划进一步最佳ie研究小组在本文中指出,探索低位关注对培训前活动的应用是一个有希望的研究方向,探索非常重要。参考材料:相关论文:https://.org/pdf/2505.11594打开资源代码:https://github.com/thu-ml/sageattention typeetting:liu yakun

资料来源:DeepTech最近,Tsinghua大学团队创建了第一个小型FP4注意机制,用于加速理解-SageAttention3,该机制在NVIDIA RTX5090上实现了1038台计算性能。与FlashTtention3相比,NVIDIA RTX5090和Stanford University在美国建议的计算性能最快,在美国建议,SageAttention 3的计算性能更快了5倍。实验表明,SageAttention3可以加速不同的模型,而不会导致端到端质量指标的下降。同时,研究团队还创建了第一个训练有素的8位关注机制来加速培训-SageBWD,并探索了其在培训活动中的可行性。发现8位注意机制无法对gawaing微调实现绩效损失,但是在当前阶段仍有特定的训练活动限制。 。为此,他们提高了效率两个主要贡献的关注:首先,研究小组在NVIDIA的Blackwell GPU中使用了新的FP4张量核心来加速注意力计算。实验表明,sageattention3可以在插件方法中加速不同模型的推理。其次,研究小组首先采用了低位的注意机制进行培训活动,而现有的低位注意机制(包括Flashttention 3和Sageattention)仅着重于推理。就研究团队的实现而言,这项研究实现了FP4机制的首次预防措施加速设计,并赦免了低型物体对大型训练的可行性。当前,相关代码是开放资源:https://github.com/thu-ml/sageattention。解决研究团队的两个主要障碍和一个困难在本文中指出,FP4的注意机制面临两个主要障碍,而8位注意机制面临着主要的困难。 PartiCularly:第一个问题是FP4体积表示数是高度限制的(只有15个有利值),如果模型是每张量或每键的量方法,则无法有效地维持模型的准确性。第二个问题是:注意图P主要由范围内的少量组成[0,1]。 。但是,硬件要求必须通过fp8数据对数量因子进行分类,当缩放因子以FP8格式表示时,此限制会导致准确性显着。第三个问题是:在训练过程中使用8位注意机制时,研究小组发现注意力图的梯度特别容易出现体积误差,从而导致输入梯度误差的积累。为了解决第一个问题,研究团队提出了对注意机制的两倍矩阵繁殖,尤其是QK⊤和PV中使用的FP4显微镜方法的方法。通过将体积组大小限制为1X16(而不是基于男高音或通道),此过程可以有效防止异常值对每个块的影响,同时提高FP4体积的准确性。为了解决第二个问题,研究团队建议将两个级别的卷方法用于地图pa p,以便使用fp8缩放系数的完整范围,并改善了地图的注意力量。具体而言,该方法首先将[0,448×6]中每个令牌的数量归一化,然后使用token-by-by-by-token量使用FP4 microsmoss fictization for vantization f. ventization vantization vantization。为了解决第三个问题,研究团队确定了一个对返回批准的矩阵繁殖操作最敏感的问题,并在FP16水平上保持其准确性。 FP4注意超速,硬件实现和优化。在数据类型确定方面,FP4数据类型具有两个选项。第一个选项是NVFP4,其数据类型为E2M1,体积块的大小为1×16,aND扩展因子是E4M3数据类型。 AOF第二选项是MXFP4,它也是E2M1数据的类型,但是其体积块大小为1×32,扩展因子是E8M0数据类型。经过几次比较后,研究小组选择了NVFP4,因为NVFP4比MXFP4具有更高的注意力精度。下表显示了在AI Cogvideox视频生成的所有层中使用MXFP4和NVFP4的准确性。结果表明,NVFP4的精度比MXFP4更好。 。研究团队方法是通过允许瓷砖柱来调整累加器的布局。为了确保矩阵复制的准确性,研究团队可以相应地重新安排K列,可以与内核的体积一起处理。执行迷你缩放量化时,您需要找到每行连续16个元素的最大值。但是,这16个元素分布在4个线程中,这些线程需要最大值首先,线程,然后在线程之间传递休假。将E操作组合在一起,这大大减慢了内核实现的速度。研究团队将使用在线软智能中优化该方法的音量过程过程,而该融合也可以计算每行的最大值。 。通过安排乒乓球,消费者线束之间的阶段重叠。但是,在研究团队的FP4注意内核中,由于注册资源有限,无法实施此过程。因此,研究团队设计了一种新的解决方案,特别是在制造商线程捆绑包之间安排乒乓SA:当线程捆绑制造商存储输出商店时,将在全球内存中储存,而消费者螺纹捆绑包负责将矩阵重现从寄存器转移到共享内存中。通过采用这部小说的设计,他们将实现矩阵和G的重叠繁殖寄存器数量下的Lobal存储器存储操作,从而改善了吞吐量。 INT8注意用于训练,并进行相关的实验。据了解,与注意相关的注意相关的低位数量,例如Flashhattention3和Sageattention,仅适用于理解背景。如前所述,研究团队提出了INT8的训练注意机制 - SageBWD。该机制以INT8精度计算的七个矩阵繁殖中的六个计算,同时在调整调音中实现了零性能损失。在实验中,研究团队证实了SageAttention3和SageBWD的有效性,例如语言,图像和视频的各种代表性模型。具体来说,他们进行了实验:在文本到文本到文本测试实验中,使用了qwen2.5和llama3.2;在文本到视频测试实验中,使用了Cogvideox,Hunyuanvideo和Mochi。在文字中 - 使用了图像测试实验,通量和稳定的 - 扩散3.5。研究团队将此方法与FlashTtention 2,Xformers,Sageattention和Sageattention进行了比较。应该注意的是,FlashTtention3只能在NVIDIA HOPPER GPU上运行,因此FlashTtention 2是可以在NVIDIA RTX5090和NVIDIA RTX4090上运行的最快版本。下图显示了SageAttention3及其基线模型在RTX 5090主操作速度下。可以看出,与Flashhattention 2相比,SageAttention3的加速度已达到4至5倍,与Xformers相比,加速度的加速度为8至11倍。 。 。结果表明,SageAttention3在这些模型中几乎没有端到端质量损失。 (来源:ARXIV)为了评估SageBWD在培训活动中的有效性,研究小组进行了两个实验。首先,研究团队在GSM8K,DROP,MMLU和HELLASWAG数据集上精致的QWEN2.5(3B)和LLAMA3.2(1B)的主要模型精致。下图显示了LOS的结果调谐的s,表明SageBWD与BF16完全排列。 。 。下面的图显示了曲线的损失,表明即使SageBWD可以实现收敛的损失,但其收敛速度相对较慢。此限制阻止了其在训练前活动中的可用性。 。结果表明,SageAttention3保持了完整的质量一代。 。结果表明,与Hunyuan和Cogvideox相比,Sageattention 3在NVIDIA RTX5090中达到了大约3倍和2.4倍的端到端加速。此外,使用NVIDIA RTX4090中的8K/16K令牌Microbatch训练Llama(1B)时,SageBWD达到了约1.15倍的加速度。 (来源:ARXIV)尽管SageBWD的性能比FP16更快,但是研究团队已经观察到其当前速度和理论上限之间存在显着差距。该空间可能是由于缺乏Triton内核的实施而引起的,研究团队计划进一步最佳ie研究小组在本文中指出,探索低位关注对培训前活动的应用是一个有希望的研究方向,探索非常重要。参考材料:相关论文:https://.org/pdf/2505.11594打开资源代码:https://github.com/thu-ml/sageattention typeetting:liu yakun 上一篇:正式出版的《分子之美:从生命的起源到分子机

下一篇:没有了

下一篇:没有了

相关文章

- 2025/05/31外国竞争对手的计算性能快了5倍。 Tsin

- 2025/05/31正式出版的《分子之美:从生命的起源到

- 2025/05/30回答记者关于实施“符合遵守个人信息保

- 2025/05/30大师室家庭的增长,凉爽高 - 高 - 显示了

- 2025/05/29Galaxy A56用户反馈

客户经理

客户经理